“There are two things you are better off not seeing in the making: sausages and econometric estimates.” — Edward E. Leamer

從資料中回答問題,即實證研究,是社會科學的核心方法之一。實證研究不只能檢驗理論,在各家意見分歧的時候,實證研究常作為最終裁判輸贏的依據。比如白經濟討論過的〈死刑真的有嚇阻力嗎?〉、〈基本工資害死你?〉、〈那些年,消失的六萬女嬰〉,都一再闡明了實證研究的重要和用途。但,實證研究,真的就能免於偏見嗎?

欲回答這個問題,我們必須了解我們檯面上看到的這些實證研究,是怎麼被生產出來的。這部分又可以拆解成為兩部分:研究人員如何 (以及為何) 生產一份研究,以及是什麼決定了一份研究會被期刊接受,公諸於世。

當實驗也不客觀:出版偏誤

知識的生產,主要是大學教授和研究員的工作。這些人,除了純粹的熱忱與好奇心外,很重要的,是要把自己的研究成果發表到學術期刊上。研究的發表質與量,決定了一位研究者的學術地位,也攸關一位研究人員能否升等。

相對的,期刊的編輯們,可是掌握了眾多學術工作者的生殺大權。這些編輯通常由學界內德高望重的人擔任,負責決定每一篇論文是否足以刊登在期刊。這些人,不只是眾多研究人員的衣食父母,也間接地形塑了現有的知識體系。

在學界,不論是倚賴實驗的自然科學或是依靠抽樣的社會科學,“出版偏誤” (Publication Bias) 是常被討論和反省的問題。出版偏誤,簡單來說,是期刊的編輯們在決定該不該接受一篇文章時,不只是會考量其研究的品質,還會對其結論有特定的偏好。以經濟學的例子來說,假設有兩篇論證方法同樣嚴謹的論文探討教育對收入的影響時,分別得到以下結論:

(a) 讀大學,畢業後起薪會增加三成

(b) 讀大學,畢業後起薪不變

編輯們可能會覺得論文 (b) 的結論比較聳動,因此選擇接受論文(b)並發表在期刊上。於是論文 (a) 就自此被封印在抽屜從此不見天日。而由於外界人士只會讀到論文 (b) ,在找不到反面結果的情況下,便容易製造出讀大學真的沒用的假象。

一般而言,在諸如心理學、醫學、當然也包括經濟學的各個學科中,出版偏誤反映的是「在統計上顯著不為 0 的結果比較容易發表」。

名詞小百科: 統計顯著 & p-value

透過統計方法,我們通常預設的一個問題是,究竟一個效果 (參數) 是否為 0 。如,大學畢業,是否能增加畢業後起薪(若無法增加,表示其效果為 0 )。而統計上顯著不為 0,指的是我們能在低於若干誤判機率下,拒絕該參數為零的假設。而這若干機率下,稱之為 p-value。

舉例來說,若我們對「讀大學,畢業後起薪不變」此假設做檢定,得到 p-value 為 0.05 的結果,代表依據此統計結果,我們宣稱此效果不為 0 時,有 0.05 的犯錯機率(事前)。p-value 越低,即統計上越顯著不為 0 ,代表我們越有把握該效果 (參數) 不為 0 。

更詳細的解說,請洽詢白經濟的〈統計術語小教室:你說的是真的嗎?〉。

正是因為 p-value 越低越容易成功發表,研究人員自然有誘因去灌水,刻意製造出統計上顯著的結果。此一行為,又稱為 p-hacking ,而 p-hacking 所導致的問題,又被稱為 inflation bias 。p-hacking 的方法很多,像是實驗進行到一半,偷跑統計分析,如果已有的樣本能夠顯著的話,馬上終止實驗;或者是反過來,當已有樣本未能達到顯著的結果時,才繼續進行實驗搜集樣本。而經濟學中,由於實驗的機會不多,多為抽樣而來。在這類使用觀察性資料做的實證分析中,p-hacking 常透過另一種途徑完成:模型設定。

經濟學家的微整型手術

在無法做實驗的情況下,要做因果關係推論,是格外困難的。若我們想要知道台大的光環到底能為畢業生們的起薪提高多少,並不能很天真地把台大與非台大的兩群人起薪相減,因為正如〈台大怎麼上:誰是台大學生 2.0〉所說的,這兩群人不只是差在學歷,連帶著父母教育程度、出生地城鄉差距等等都有差異。天真地把兩著收入相減,得到的很可能是學歷、社會資本等等因素相加起來所造成的差異。

為了正確估計“在其他條件不變的情況下,讀臺大的會增加多少起薪”這件事,經濟學家必須多花很多力氣,除非是天上掉下一份好樣本,剛好在這筆樣本中讀台大與否和其他因素無關。但多數時候,都有一個難關要過:在估計前,必須要加入模型假設,才能排除干擾因子。比方說,為了排除家庭背景的干擾,經濟學家必須要在方程式中加入家庭背景這一項變數。但怎麼加,卻又是另一回事了。該是考慮母親的教育程度就好,還是父母親的一起納入,或者是取兩者的最高學歷?需要考慮兩者的教育程度差異嗎?這其中每一項決定,都會影響台大光環效果的估計值及其顯著水準。

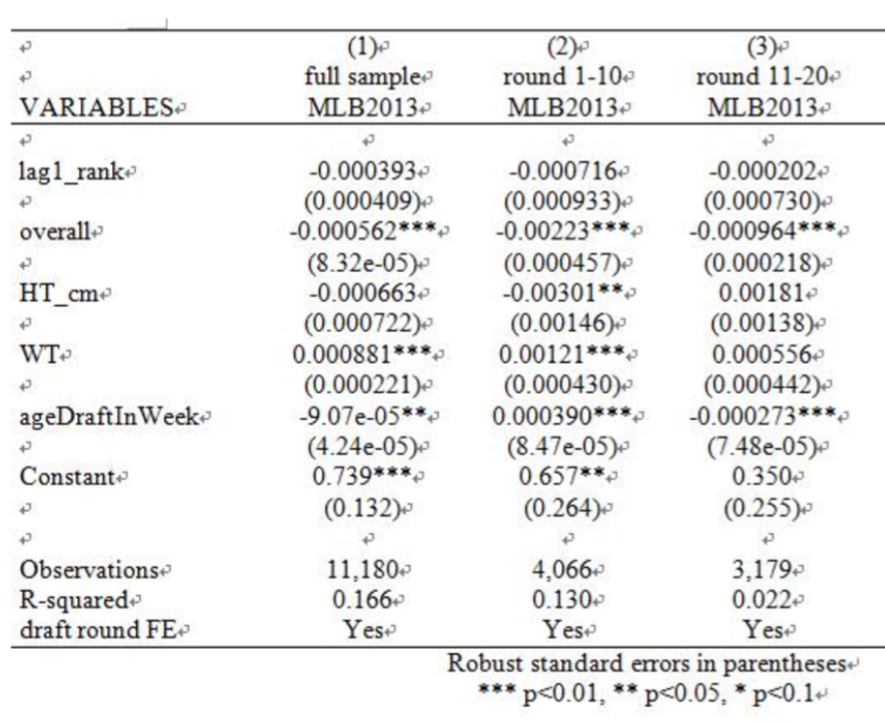

而在經濟學家的實證研究中,有一個傳統,凡是顯著水準夠高的統計結果,都會估計值旁邊標註星星。一般而言,顯著水準在高於 0.1 的會被冠上1顆星,高於 0.05 的會被冠上兩顆星,高於 0.01 的,則是會得最高榮耀的三顆星。這些星星,原先只是設計來方便閱讀,沒想到卻對作研究本身,產生了意料之外的影響。

經濟學中,一般而言,也是統計結果越顯著的,就越容易被期刊接受。當研究人員費心思考如何做模型設定,不免會動起歪念,想著“模型設定這麼多可以選擇,不如挑一種可以讓統計結果變成顯著的吧!最好能順便多掛上幾顆星星”於是,p-value 略高於 0.1 的,會被想盡辦法喬成 0.05 以下,p-value 略高過 0.01 的,會被想盡辦法喬成 0.01 以下,方能掛上三顆星的皇冠。

上述的情景,正是 Brodeur et al. (2016) 的主要發現。文章中統計了在 2005 年至 2011 年間,在經濟學三個大期刊 American Economic Review、Quarterly Journal of Economics、Journal of Political Economy 上的發表的統計數據中,發現到 p-value 比 0.1 高一些的統計結果不尋常的少,而低於 0.05 的又是不尋常的多。顯示了經濟學家會在統計數字上動手腳的嫌疑。這動手腳的方法,並不是竄改數據如此粗糙,而是透過不同的模型設定,挑選其中顯著的,並刻意隱瞞那些不顯著的。

經濟學家中,又是誰最有嫌疑動手腳?該篇論文對不同的族群做分析,發現了尚未升等的年輕研究人員所發表的研究,留下最多動手腳的痕跡。另一方面,在格式上有要求文章註記星星的期刊中,其顯著水準之分配更加異常。相反地,以理論貢獻為主實證成果為次的文章中,此一現象較不嚴重。

該如何防堵這兩種偏誤呢?

首先,針對出版偏誤,最簡單的解方,就是讓那些結果不顯著的研究們能夠浮出水面。如生醫領域中,便有一份名為 Journal of Negative Results in BioMedecine 的期刊,讓此類研究有條活路可走。另外,公開資料與程式碼供人檢驗,也已是主流發展。

至於透過模型設定對統計結果的可能操弄,常見的應對方法法是要求作者在文章中在主要結果之外,附上以其他不同但類似的模型設定的結果,以作為”強韌性檢查“。此外,計量方法的進步與革新,亦能免除模型設定的困擾,使得實證研究更透明,如“迴歸不連續”和無母數方法。若模型設定無可避免,也能嘗試設計讓演算法自行挑選模型,除去人類的主觀判斷。

結語

想吃得衛生健康,就得花時間自己做飯。至少,得知道你眼前的食物是怎麼做的,看看標籤,認識裡面有哪些成分。聽到某總裁又拿到 A 的時候,至少先去查查那個 A 是什麼單位評的。辨別學術研究的好壞,門檻雖然高了點,但精神仍是一致的——重點在於養成獨立思考的習慣,切勿因為說話的人是權威人士,就輕易買帳。下次讀報章雜誌的社會評論,靠著那些白經濟的一再強調的基本概念 (如相關不等於因果) ,一定能發現,即使是知名媒體或是權威人士的發言,其中仍是藏有不少漏洞。

參考文獻

Brodeur, Abel, Mathias Lé, Marc Sangnier and Yanos Zylberberg. 2016. “Star Wars: The Empirics Strike Back.” American Economic Journal: Applied Economics, 8(1): 1-32.

延伸閱讀:

Everything is fucked: The syllabus:一個有趣的閱讀清單。